Von Cyberangriffen geht eine immer größere Bedrohung für Unternehmen aus. Laut Bitkom beläuft sich der Schaden für die deutsche Gesamtwirtschaft pro Jahr auf über 200 Milliarden Euro. Viele Firmen gehen davon aus, die wichtigste Schutzmaßnahme sei, sich eine Reihe von teuren IT-Sicherheitsprodukten einzukaufen und zu betreiben. Dies ist allerdings eine Fehlannahme, die weitreichende Konsequenzen mit sich ziehen kann, denn in der Praxis ist IT-Sicherheit kein Produkt, das man kaufen kann, sondern wird nur durch einen kontinuierlichen und ganzheitlichen Prozess erreicht.

Die IT-Sicherheitswelt ist übersät mit Buzzword-gefüllten Marketingversprechen, hinter denen sich oft nur heiße Luft verbirgt. Wichtige Grundlagen, die für einen sicheren IT-Betrieb essenziell sind, geraten dadurch im Diskurs leider in den Hintergrund. Der Grund dafür liegt auf der Hand: Softwarelösungen, die versprechen, nur durch eine unkomplizierte Installation Abhilfe zu schaffen, lassen sich wesentlich besser vermarkten als ein kontinuierlicher Prozess, bei dem das Unternehmen selbst tätig werden muss.

Produkte wie Antiviruslösungen können zwar im Kontext eines Defense-in-Depth Modells eine zusätzliche Hürde für Angreifer darstellen, dürfen aber nie die Hauptschutzmaßnahme sein. Beispielsweise erleben wir bei unseren Ransomware-Simulationen immer wieder, dass unsere eigens entwickelte Ransomware nicht vom Antivirenprogramm erkannt wird. Dies spiegelt auch die Realität von Ransomware-Angriffen wieder, denn fast alle Opfer setzen eine Virenschutzlösung ein. Die Kriminellen scheint das allerdings nicht zu stören: Bundesweit wird jeden Tag mindestens ein neuer Ransomware-Angriff polizeilich erfasst, bei einer geschätzten Dunkelziffer von bis zu 90 Prozent.

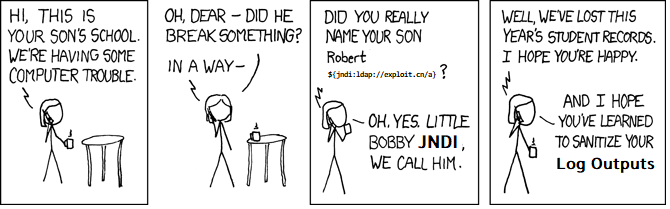

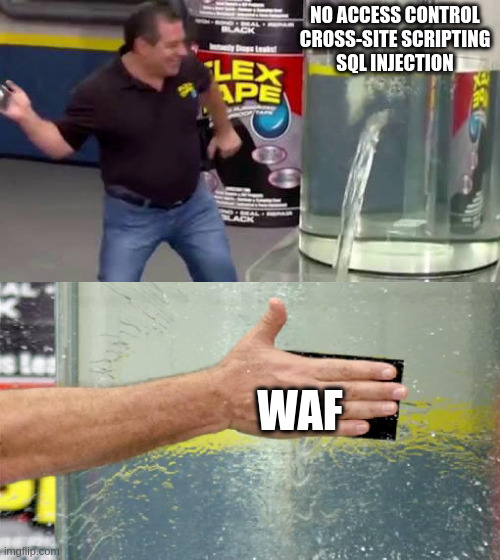

Im Betrieb von Webapplikationen setzen viele Firmen sogenannte Web Application Firewalls (WAFs) ein, die bösartige Requests erkennen und blockieren können, und gehen davon aus, dass Schwachstellen in der darunterliegenden Webanwendung nicht mehr ins Gewicht fallen. Zwar machen WAFs es in der Tat schwerer, vorhandene Schwachstellen auszunutzen, können aber durchaus umgangen werden, was uns in unseren Penetrationstests regelmäßig gelingt. Es ist also wichtig, IT-Sicherheit in den Softwareentwicklungsprozess zu integrieren, sodass Schwachstellen erst gar nicht entstehen.

In einem IT-System, in dem wichtige Grundprinzipien nicht befolgt werden, wirken solche Produkte also wie ein Heftpflaster auf einer klaffenden Fleischwunde. Eines dieser Prinzipien ist ein effektives Patchmanagement, denn auf der technischen Seite ist veraltete Software das größte Einfallstor für Angreifer, die bekannte Sicherheitslücken ausnutzen um in Systeme einzudringen. Das schnelle Einspielen von Sicherheitsupdates ist daher essentiell, um es Angreifern so schwer wie möglich zu machen.

Des Weiteren stellen wir in unseren Penetrationstests häufig fest, dass einfache, aber wichtige Maßnahmen zur Härtung des internen Netzes nicht umgesetzt werden. Leicht abschaltbare Defaulteinstellungen der Active Directory-Umgebung ermöglichen es einem ins interne Netz vorgedrungenen Angreifer sich ungehindert auszubreiten, und das gesamte IT-System zu übernehmen. Auch hier kann kein Produkt das Problem beseitigen, sondern das bestehende System muss vonseiten der Systemadministration sicher konfiguriert werden.

Ausschließlich technische Maßnahmen zu ergreifen ist allerdings nicht ausreichend, denn für Angreifer sind Social Engineering-Angriffe, wie beispielsweise Phishing-Emails, meist der erste Schritt um ins interne Netz zu gelangen. Der Grund dafür ist, dass der Faktor Mensch in den meisten Fällen leichter auszuhebeln ist als technische Systeme. So gelingt es uns bei unseren Phishing-Kampagnen oft, die Passwörter von über 20 Prozent aller Mitarbeiter zu erbeuten, eine erschreckende Zahl in Anbetracht dessen, dass im Zweifel ein einziger Erfolg reicht, um größeren Schaden anzurichten. Die Sensibilisierung der Mitarbeiter für solche Angriffe ist daher essenziell.

Um sich effektiv vor Cyberangriffen zu schützen muss ein Unternehmen also für seine IT-Sicherheit selbst Verantwortung übernehmen und in seine eigenen Prozesse integrieren. Softwareprodukte und Dienstleistungen können dabei unterstützen, sind aber kein Allheilmittel. Um das aktuelle Sicherheitsniveau zu bestimmen, empfiehlt es sich, regelmäßige Sicherheitsanalysen wie Penetrationstests oder Phishing-Kampagnen durchzuführen. Wir von CRISEC unterstützen Sie gerne dabei.

Dieser Beitrag wurde verfasst von Jonas Mönnig.